Commission spéciale chargée d'examiner le projet de loi relatif à la bioéthique

Réunion du mercredi 4 septembre 2019 à 18h45

Résumé de la réunion

La réunion

COMMISSION SPÉCIALE CHARGÉE D'EXAMINER LE PROJET DE LOI RELATIF À LA BIOÉTHIQUE

Mercredi 4 septembre 2019

L'audition débute à dix-huit heures quarante-cinq.

(Présidence de Mme Agnès Firmin Le Bodo, présidente)

La commission spéciale procède à l'audition de M. Claude Kirchner, directeur de recherche émérite de l'Institut national de recherche en informatique et en automatisme (INRIA) et conseiller du président de l'INRIA, Pr Serge Uzan, vice-président du Conseil national de l'Ordre des médecins, et M. David Gruson, fondateur de l'initiative « Ethik IA », membre du comité de direction de la chaire Santé de l'Institut d'études politiques de Paris, professeur associé à la faculté de médecine Paris-Descartes.

Notre journée s'achève avec un sujet qui sera pour la première fois abordé dans une loi de bioéthique : l'intelligence artificielle (IA) vue sous l'angle des algorithmes, ce qui peut déjà susciter quelques questions. La mission d'information s'était penchée sur le sujet à l'hiver dernier. Nous devons donc en connaître mieux qu'auparavant certains enjeux. Pour faire le point plus précisément sur les avancées et éventuellement les lacunes du texte qui nous est proposé, j'accueille M. Claude Kirchner, directeur de recherche émérite de l'Institut national de recherche en informatique et en automatisme (INRIA) et conseiller du président de l'INRIA, le professeur Serge Uzan, vice-président du Conseil national de l'ordre des médecins, et M. David Gruson, fondateur de l'initiative « Ethik IA », membre du comité de direction de la chaire Santé de l'Institut d'études politiques de Paris, professeur associé de la faculté de médecine Paris Descartes.

Je suis vice-président de l'Ordre des médecins, chargé des questions de recherche, d'enseignement et d'intelligence artificielle, mais je dirige aussi la stratégie de l'Institut universitaire de cancérologie. Aujourd'hui, j'exprimerai ma position personnelle, la position de l'Ordre des médecins n'ayant pas encore été arrêtée. Cette précaution énoncée, l'Ordre des médecins s'est intéressé depuis longtemps au sujet puisque début 2018, sous la direction du Pr Jacques Lucas, il a produit un document qui s'appelle Médecins et patients dans le monde des data, des algorithmes et de l'intelligence artificielle.

Chaque fois que j'interviens sur ce sujet, que ce soit auprès de médecins ou de patients, le sentiment qui domine est l'inquiétude sur le caractère disruptif de l'intelligence artificielle dans la relation médecin-patient. Chaque fois, j'essaie d'expliquer que nous n'allons pas passer brutalement de l'ancienne à la nouvelle médecine. Nous allons conserver ce qui est excellent dans notre système de santé, en particulier sur le plan humain et social, et l'améliorer grâce à l'IA. Quels sont les domaines où l'IA va impacter la santé ? Je récuse le document provocateur d'un de nos ex-confrères ou confrères qui disait : « demain, il n'y aura plus que la médecine générale qui résistera à l'intelligence artificielle ». C'est faux. En revanche, tous les domaines vont utiliser l'IA, que ce soit la prédiction, le dépistage, bien sûr l'imagerie, mais également le choix de la stratégie thérapeutique, la qualité et la pertinence des soins et puis aussi beaucoup la formation des soignants. Nous utilisons beaucoup d'IA pour la simulation, mais également pour le traitement des patients. Demain, quand nous opérerons un patient – je l'ai vu et nous le testons par exemple chez Dassault Systèmes – on aura une espèce de clone du patient issu de l'imagerie sur lequel on pourra tester certaines hypothèses de traitement chirurgical ; l'IA aura donc un impact sur tout le soin impliquant un choix. Je dis aux médecins que l'IA va libérer du temps médical pour mettre à profit l'intelligence émotionnelle qui est essentielle dans la relation médecin patient.

Un point sur le contexte général : pendant longtemps, il y avait des médecins à « bac plus 12 » qui travaillaient avec des personnels paramédicaux ou non médicaux à « bac plus 3 ». Le fossé entre les deux types de formation suffisait à stratifier le mode d'exercice. Aujourd'hui, il y a des formations intermédiaires, il y a de nouveaux métiers, il y a des formations de cinq ou six ans, il y a des compétences qui sont en voie d'extension. Le risque est dans les dysfonctionnements liés à des problèmes de cohabitation à l'intérieur d'une équipe. C'est pourquoi je dis à tous les médecins que s'ils veulent garder une place spécifique, elle ne peut être liée qu'à la responsabilité qu'ils devront assumer dans la décision et la synthèse de la décision. Le panorama est rendu encore plus complexe en raison du rôle croissant des patients : les associations, ce qui est parfaitement normal, mais aussi les patients qui font des études. Sorbonne Université accueille une université des patients, des patients accompagnateurs, des patients experts, etc. Pour résumer, j'aime bien utiliser deux termes anglais : ne va-t-on pas passer d'une médecine aidée par les données, data assisted, à une médecine guidée exclusivement par les données, data driven ? Si nous formons bien les médecins, il n'y a aucun risque que cela advienne.

Je voudrais d'emblée insister sur les dangers de l'IA. J'ai la chance de participer à un groupe de travail de l'Institut Montaigne sur les biais algorithmiques. C'est un sujet majeur. Les algorithmes seront considérés comme des espèces d'oracles, de grands vaudous, mais ils sont parfois truffés de biais, d'autant que beaucoup fonctionnent sur le modèle de la boîte noire, c'est-à-dire que nous ne savons pas ce qui se passe à l'intérieur. Il faudra faire très attention. Nous devons former les médecins à l'IA. Actuellement les doyens réforment le deuxième cycle des études médicales. C'est le moment de l'y intégrer ainsi que, bien sûr, dans le troisième cycle. J'ai insisté sur ce point auprès des instances décisionnaires – vous savez que j'ai été à l'origine d'un rapport sur la recertification des médecins.

L'IA est absolument essentielle à la recherche. Il faut aller vers un partage facilité des données de santé et des données nécessaires à la recherche. La France a créé un Health Data Hub, et tout le système doit être parfaitement organisé. On peut nourrir beaucoup d'espoir, mais il faut d'abord apprendre aux médecins qu'un résultat surprenant obtenu grâce à un algorithme peut être l'occasion d'une découverte médicale. Par exemple, une étude algorithmique sur le risque de cancer du sein a conduit à découvrir que certaines femmes ont moins de risques, parce qu'elles ont un taux de cholestérol un peu élevé. C'est le traitement anticholestérol qui agit sur un des facteurs de risque de cancer du sein. L'utilisation des données massives par l'IA permettra donc peut-être de faire avancer la recherche. N'oublions pas que Claude Bernard, qui avait créé la méthode expérimentale, a passé vingt ans de sa vie à essayer de savoir si le curare agissait sur le nerf ou sur le muscle. Il ignorait l'existence de la jonction neuromusculaire. On peut raisonnablement penser que l'IA aurait suggéré l'existence possible de cette étape.

Avant de conclure, je voudrais évoquer deux points. Aujourd'hui, il faut amener des éléments de garantie sur les algorithmes, au même titre qu'il faut avoir des éléments de garantie sur le médicament. Certification ou labellisation des algorithmes, nous ne pouvons pas les laisser en l'état. Le projet de loi prévoit que les médecins devront expliquer aux patients comment fonctionne l'algorithme ; l'immense majorité en sera incapable, parce qu'ils n'ont pas été formés à cela. Quelqu'un devra avoir fait en amont le travail de sécurisation, et les notices qui accompagnent les algorithmes devront être améliorées. En conclusion, un médecin doit être formé à savoir ce qu'il peut attendre de l'IA. Il doit être capable de rejeter un résultat qui n'est pas compatible avec ce qu'il a appris et les données dont il a connaissance. N'oublions pas que la compréhension de ce qu'est un algorithme commence à l'école.

L'IA devra donc nous aider tout en restant un outil au service d'une relation humaine et humaniste. Ainsi, la confiance réciproque entre le médecin et son patient – c'est très important, les patients attendent qu'on les traite comme on traiterait quelqu'un de notre famille –, renforcée par les données de la science et de l'IA, leur permettra d'avoir une conscience commune de leur objectif.

Je vous présenterai les points de vue développés dans le cadre d'INRIA et dans celui du Comité consultatif national d'éthique (CCNE), car j'ai travaillé avec David Gruson à l'élaboration d'un rapport pour le CCNE visant à mieux comprendre les interactions entre numérique et santé.

Il faut bien comprendre que l'expression « intelligence artificielle » est un buzzword qui appartient au développement d'une thématique scientifique et technologique qui est le numérique. Dans le numérique, sont développés un certain nombre de corpus qui vont de l'informatique à l'automatique, la robotique, les mathématiques, l'électronique, etc. Dans ce cadre-là apparaissent un certain nombre de processus que, depuis les années 1950, nous avons qualifiés d'intelligence artificielle et qui aujourd'hui, prennent une visibilité beaucoup plus grande. Mon propos portera sur l'ensemble du numérique et pas uniquement sur une certaine classe d'objets qui sont qualifiés d'intelligence artificielle.

Il nous faut d'abord comprendre pourquoi les sciences et technologies du numérique ont un tel impact sur l'humain et sur la société. L'introduction de l'électricité, de la mécanique a eu un impact fort, mais l'impact que nous voyons aujourd'hui sur l'ensemble de la société est bien plus profond. À mon sens, cela vient du fait que les systèmes de traitement de l'information numérique travaillent avec les systèmes d'information biologique que nous sommes. Nous sommes chacun d'entre nous, ici, des systèmes d'information biologique qui vont capter de l'information, des images, du son. Vous êtes en train de traiter cette information en essayant de la comprendre, de lui donner un sens, etc. La combinaison entre les systèmes de traitement des informations numérique et biologique conduit à une transformation majeure de la société. Le professeur Uzan a bien décrits ces impacts dans tout ce qui concerne la santé et le système de santé, que ce soit pour la télémédecine ou en salle d'opération. Cette transformation intervient partout : les associations de patients, les réseaux sociaux qui vont permettre aux patients de s'éclairer mutuellement, mais aussi de donner leur avis sur les médecins ou sur le système de santé. Cette dynamique change profondément la relation entre le patient, les médecins et l'ensemble de l'environnement. La numérisation globale va toucher l'ensemble de la société et l'ensemble du système de santé – la recherche clinique, la recherche en santé publique, la gestion des établissements, l'aide au diagnostic, etc. Dans ce contexte, les compétences demandées aux médecins et à l'ensemble des personnels de santé sont obligées d'évoluer. Le professeur Uzan l'a très bien dit : il est fondamental de former l'ensemble de la population, depuis la maternelle, à comprendre les concepts fondamentaux de l'informatique et du numérique, mais il faut aussi faire en sorte que dans le système de santé les professionnels maîtrisent les compétences qui leur permettront de comprendre ce qu'il est en train de se passer et comment ils peuvent l'utiliser.

Des situations totalement nouvelles apparaissent. La télémédecine permet d'accéder à des informations qui étaient inaccessibles auparavant. Ceci va modifier profondément la manière dont on va consulter en France ou dans le monde, d'ailleurs dans les deux sens : des patients étrangers pourront consultent la médecine de très bonne qualité dont nous bénéficions en France et, réciproquement, des patients français pourront consulter à l'étranger et, d'une certaine façon, modifieront la façon dont fonctionne le système français de santé, qui est unique au monde avec une forte mutualisation et un accès aux soins particulièrement égalitaire, ce qui ne se retrouve pas nécessairement partout.

Nous allons être sollicités sur les enjeux éthiques qui se posent dans ce contexte-là, notamment autour du consentement. Comment gère-t-on le consentement quand les données sont persistantes ? Cette persistance et la capacité à pouvoir accéder à des données que nous n'avions pas auparavant sont un vrai progrès, mais il faut savoir le gérer sur le long terme – et par « long terme », je veux dire ici « l'éternité ». C'est particulièrement important pour la gestion des données génétiques ou d'autres données par nature très confidentielles.

Tout médecin a accès aujourd'hui aux outils numériques qui sont offerts à l'ensemble de la population, notamment les réseaux sociaux ou les outils qui permettent d'échanger du courrier de façon soi-disant gratuite. En fait, ce type d'outil ne préserve pas l'anonymisation ou la confidentialité des échanges. Il faut que les médecins sachent se positionner pour faire en sorte qu'ils utilisent des outils qui leur permettent d'agir de façon éthique, y compris de ce point de vue-là.

Le rapport co-écrit avec David Gruson comme l'avis n° 129 du CCNE évoquent les questionnements éthiques liés à l'« augmentation » de la personne humaine. Certains seront bien sûr portés par le système de santé, mais la société sera confrontée à la tentation du contournement de l'interdit : « je veux me faire augmenter ; c'est possible en France, je le fais, ce n'est pas possible en France, je vais chercher ailleurs ». Nous ne pouvons plus réfléchir comme si les frontières étaient étanches.

Je m'exprimerai à titre personnel, dans le sillage du rapport auquel j'ai eu l'honneur de contribuer avec Claude Kirchner, et dans la ligne des recommandations portées par Serge Uzan et l'Ordre des médecins, notamment Jacques Lucas, qui avaient permis de faire la liaison avec le travail du CCNE. J'y ajouterai une coloration juridique à partir de ce qu'est le projet de loi aujourd'hui et je vous dirai ce pour quoi je pense que le point d'équilibre trouvé dans ce projet est sans doute le bon. J'y ajouterai une note plus économique sur la fabrication de l'innovation.

Depuis la mi-juillet, j'ai rejoint le groupe Jouve, une entreprise au capital français avec des data centers sur le territoire national. Comme le disait très bien Claude Kirchner, il y a aussi un enjeu sur le maintien d'un écosystème de production de l'innovation sur le territoire national et européen. En phase avec « Ethik IA », nous avons dit au CCNE qu'il serait non éthique de bloquer l'innovation – c'est sans doute un principe fondamental à avoir en tête. Une logique de surréglementation, dans l'environnement déjà le plus protecteur au monde depuis l'entrée en vigueur du Règlement général sur la protection des données (RGPD), risque de créer un effet de complexité sur le développement d'innovations. L'innovation en IA médicale se développe très vite et, dans un contexte où le numérique rend les systèmes de santé de plus en plus poreux entre eux, le risque est évident que nos concitoyens et les professionnels se tournent vers des solutions conçues hors du cadre du RGPD et dont nous ne pourrions pas garantir le caractère éthique a priori. C'est pour cela que l'article 11 du projet de loi me semble traduire un très bon point d'équilibre. En effet, il met en œuvre assez directement des recommandations qui avaient été formulées par le CCNE et dont nous avions discuté avec Jean-Louis Touraine et les membres à la mission d'information, avec l'idée d'un devoir d'information préalable du patient avant l'application d'un traitement qui s'appuierait sur une base de recommandations algorithmiques. C'est la traduction du principe d'une garantie humaine de l'IA. C'est un beau principe. Serge Uzan l'a formulé avec des mots empreints d'éthique médicale. Je vais vous en donner une lecture un peu plus juridico-opérationnelle.

Le principe de garantie humaine repose sur l'idée qu'il faut établir un certain degré de supervision humaine, non à chaque étape du processus, au risque de bloquer la capacité d'innovation algorithmique, de perfectionnement informatique, mais à des points critiques. Le repérage des points critiques du processus implique d'inscrire ce principe de garantie humaine dans la loi puis de le décliner opérationnellement – ceci peut prendre la forme d'un dispositif de pilotage de la qualité – en travaillant sur la construction d'outils permettant de repérer quels sont, au cas par cas, les points critiques. Par exemple, avec les équipes de l'institut hospitalo-universitaire Imagine de l'hôpital Necker, nous avons essayé de construire un prototype de référentiel de bon usage de l'IA appliqué aux données génomiques qui repère une série de points sensibles. À charge ensuite pour l'autorité de régulation, la Haute Autorité de Santé (HAS), d'émettre des recommandations pour faire partager l'intérêt de ces lignes de conduite et recommandations de bonnes pratiques pour l'application de la garantie humaine dans l'usage des algorithmiques.

Grâce au travail qui a été porté par la mission d'information de l'Assemblée, par les institutions, le Conseil de l'Ordre des médecins, le CCNE, etc., le message se diffuse. La notion de garantie humaine de l'IA est reprise dans des cercles académiques, ainsi que par la Commission européenne et désormais l'Organisation mondiale de la santé (OMS), qui a réuni un groupe de travail sur l'éthique appliquée de l'IA. Quand je discute de ce sujet dans un cercle académique ou opérationnel, mes interlocuteurs trouvent cette notion – qui a son origine en France – empreinte de beaucoup de pragmatisme. Ils ne la lisent pas sous un sceau réglementariste mais ils la voient au contraire comme quelque chose qui traduit à la fois un besoin de régulation positive et un besoin de pragmatisme dans le soutien au développement de l'innovation.

Le principe de garantie humaine donnera aussi une partie de la réponse à ces questionnements qu'évoquait le professeur Uzan sur la boîte noire qu'est l'algorithme. Il est vrai que nous ne comprenons pas trop ce qu'il se passe dedans, et pourtant ça marche. De la même manière, quand je conduis ma voiture, je ne sais pas trop comment elle fonctionne ; par contre, je sais dire quand elle ne fonctionne pas.

Dans l'innovation, il faut bien distinguer l'amont et l'aval de l'autorisation. Pour l'amont, la Cour de Justice de l'Union européenne a parfaitement déterminé qu'il faut appliquer le régime de l'autorisation de mise sur le marché d'un dispositif médical : dans une décision de décembre 2017, elle a assimilé un logiciel d'aide à la prescription, un algorithme d'aide à la décision médicale, à un dispositif médical, qui doit donc suivre toutes les étapes prévues par la réglementation, y compris des contrôles portant sur le système informatique lui-même et des tests d'explicabilité pour répondre au questionnement sur la partie « boîte noire » de l'IA. Pour l'aval, une fois la labellisation obtenue, il faut assurer la récurrence des contrôles techniques, comme pour tout dispositif médical ou toute innovation thérapeutique. Par ailleurs – c'est là que la garantie humaine a toute sa force concrète –, la garantie humaine peut se déployer par des mécanismes de supervision impliquant un regard des professionnels et des patients, des utilisateurs. Nous avons porté l'idée d'un « collège de garantie humaine ». Cela peut paraître abstrait, mais soyons pratiques : à l'échelle d'un CHU comme La Pitié Salpêtrière, l'on pourrait très bien, une fois l'algorithme mis en service, impliquer un collège associant des professionnels utilisateurs, médicaux, paramédicaux, mais aussi des patients pour faire remonter d'éventuels événements indésirables à partir de cadres déterminés, de critères de gravité médicale ou de facteurs de risque, mais aussi de manière aléatoire – le collège pourrait examiner tous les deux ou trois mois, 20 ou 30 dossiers traités par IA auxquels il appliquerait un deuxième regard, humain (« comment aurait-on fait s'il n'y avait pas eu l'IA ? ») Un tel dispositif permet de piloter l'algorithme au fil du temps, de donner de la traçabilité, ce que le projet de loi prévoit à très juste titre. Il permet de maîtriser le risque d'apprentissage et de transformation algorithmique et de laisser l'innovation avancer.

D'un point de vue juridique et opérationnel, l'article 11 atteint un point d'équilibre satisfaisant. Il a même déjà une portée d'exemplarité – il ne faut pas avoir peur du mot – hors du territoire national, au niveau européen. Le secret de la réussite ne portera que sur le développement d'outils opérationnels de suivi et de pilotage de la qualité.

Il existe aujourd'hui un énorme marché des données massives. Je me pose des questions par rapport à ces données, à leur utilisation et à la manière dont elles peuvent être exploitées ou non pour la recherche. Pouvez-vous proposer des garde-fous supplémentaires sur le fait de pouvoir certifier les algorithmes ? Vous disiez que l'Institut Montaigne a réuni un groupe pour étudier les biais qui peuvent apparaître. Lorsqu'un algorithme est utilisé sur une population qui n'a pas été prise en compte dans sa construction – on pense à la population étrangère – ne risque-t-il pas d'y avoir des biais ? Cela a-t-il été quantifié ? L'avez-vous qualifié ? Les certifications prennent-elles en compte ces modalités d'alimentation des algorithmes, notamment par autoapprentissage ? Que pourriez-vous proposer pour élaborer un système de certification ? Le collège multipartite pourrait-il être ce garde-fou ?

Nous pouvons nous réjouir que le projet de loi investisse le sujet de l'IA, quoiqu'il ne le mentionne pas explicitement de manière complète. Il y aurait d'ailleurs pu avoir une définition ou une tentative de définition permettant d'aller au-delà du traitement algorithmique de données massives, car certains développements de l'IA prennent des formes variées. Je me demande s'il n'y a pas comme un écart entre la place assez importante qui avait été donnée au sujet dans les travaux des comités d'éthique et du CCNE et cet article qui, lorsqu'on le lit, ne correspond pas exactement aux vertus que vous dites y voir. Il y aura des amendements sur la certification, mais en l'état du texte, le contenu de l'article n'est pas susceptible d'emporter la confiance.

J'en arrive à une question très concrète. L'Agence de la biomédecine ne souhaitant pas voir ses missions et compétences élargies à l'IA, qui devrait réaliser la certification, la labellisation de ces techniques ? L'Agence nationale de sécurité des médicaments ? Qu'en est-il pour ce qui ne serait pas considéré stricto sensu comme un dispositif médical ?

Les machines sont précises, rapides et stupides et les humains sont négligents, lents et brillants. Tout va donc se jouer dans la complémentarité entre l'homme et la machine et dans l'éducation aux enjeux dès le plus jeune âge et jusque dans le corps médical. Il faut aussi que nous fassions des efforts sur la présence des femmes dans le secteur de l'intelligence artificielle, ne serait-ce que pour éviter des biais… Tout cela joue. Grâce à une étude sortie en juin dernier sur le rapport des Français à l'IA, nous savons que huit Français sur dix sont favorables à son utilisation parce qu'ils savent que l'IA va susciter de grandes avancées médicales.

Faisons un peu de prospective. J'aurais voulu avoir votre sentiment sur ce qui peut se passer outre-Atlantique chez Neuralink, avec Elon Musk, qui tente d'implanter des puces dans les cerveaux humains pour connecter l'homme et la machine. Cela reste de la prospective. Je voudrais également avoir votre avis sur l'utilisation des nanotechnologies en médecine, sur l'encadrement de l'impression d'organe par des imprimantes 3D – nous savons que c'est d'ores et déjà possible – et sur le traitement des données de santé qui a aussi une dimension géopolitique, comme vous l'avez écrit dans le récent ouvrage La révolution du pilotage des données de santé. Enjeux juridiques, éthiques et managériaux avec un certain Florent Parmentier, que l'on salue.

J'ai beaucoup de questions sur cette intelligence connectée ou « artificielle ». Vous avez parlé de la responsabilité civile et professionnelle des professionnels, en particulier des médecins – ils ont une obligation de moyens et pas de résultats, notamment en termes de diagnostic. Aujourd'hui, il est démontré que certains programmes d'intelligence artificielle sont capables de détecter très tôt les tumeurs infra cliniques, par définition non visibles par le clinicien radiologue. Or plus la tumeur est prise en charge tôt, plus les chances de succès du traitement sont élevées.

Je considère que l'accès à ces technologies est une question fondamentale pour notre société, car elle est « ultra smartisée » avec des connexions un peu partout. Nous sommes capables aujourd'hui de faire un bilan de santé à la fin de la journée avec nos smartphones. Donc la réflexion éthique ne peut se désintéresser de la disponibilité, de l'accès. Je m'interroge aussi sur la transparence des programmes. De très nombreux logiciels apparaissent et nous ne savons pas toujours comment ils fonctionnent. Sommes-nous capables de le savoir ? Si ce n'est pas le cas, il sera compliqué de maîtriser une évolution. Que pensez-vous du RGPD et des tentatives de construire une identité électronique de type eIDAS, comme le prévoit le règlement européen du même nom ? Nous voyons bien qu'il faut être vigilant sur la question du consentement, qui est au cœur de l'éthique. Nous sentons bien qu'avec l'accroissement exponentiel des connaissances, le consentement est en train de glisser silencieusement vers quelque chose de moins éclairé que ce que nous disent les textes et les principes philosophiques et éthiques. Enfin, vous connaissez ce phénomène abusivement appelé « loi de Moore », qui veut que tous les 18 mois la puissance des processeurs double. Ne sommes-nous pas en train de créer une dépendance massive de nos sociétés à technologie numérique avec, à la clef, une perte de contrôle – c'est la définition de l'addiction ?

Avec ce projet de loi, l'IA fait son entrée dans la loi de bioéthique. Je pense que cette dimension prendra une place encore plus grande dans la prochaine loi de bioéthique.

Dernier témoignage, on a beaucoup parlé de gilets jaunes il y a quelque temps. J'ai eu des retours sur les craintes que crée l'intelligence artificielle dans la population ; je pense notamment à un gilet jaune qui était pilote d'avion – donc pas du tout le profil habituel – et dont la crainte était de voir disparaître son métier à cause de l'IA. Des chauffeurs de taxi m'en parlent régulièrement à Paris. L'IA est peut-être aussi un progrès destructeur d'emploi, c'est un problème éthique à souligner.

Vous avez parlé du problème du consentement éclairé. Je suis entièrement d'accord. Quand nous faisions un essai clinique, je montrais souvent à mes étudiants un dessin qui me plaisait beaucoup en disant : « attention, le consentement éclairé ce n'est pas ça » ; le dessin montrait un patient avec une lampe dans la figure – comme dans un commissariat – à qui l'on disait : « tu es d'accord ou pas pour l'essai ? ». Le consentement doit être éclairé, mais la lumière ne doit pas être trop forte. Je vais être franc : c'est très difficile. Il faut quand même compter sur l'honnêteté individuelle, sur le fait que le travail se fait en équipe et qu'aujourd'hui, quelqu'un qui n'a pas une démarche éthique se remarque assez vite. Les patients ont tendance à le faire…

Je conviens tout à fait que l'IA a un rôle essentiel en matière de diagnostic, notamment pour les diagnostics infracliniques. Je voudrais quand même lever un petit doute. On parle souvent de chirurgie « robot assistée ». Certains chirurgiens, toujours en avance parce que peut-être eux-mêmes un peu en retard, disent : « demain, ce sont les robots qui vont opérer ». Non, les robots aujourd'hui n'opèrent pas : ils aident les chirurgiens à opérer, mais à la fin, c'est le chirurgien qui a toujours la main, comme le pilote. Et heureusement, car les patients veulent bien de l'IA, mais ils conservent une certaine méfiance quant à l'absence de garantie humaine. Pour nous, médecins, la plupart des consultations se terminent sur la question : « qu'est-ce que vous feriez si j'étais votre mère ? » – puisque je voyais essentiellement des patientes. Les patients veulent que nous soyons aidés et que nous utilisions le maximum de données. Vous avez à cet égard abordé la question de l'égalité et de l'équité d'accès à la santé et aux technologies de santé. Nous sommes dans un pays où l'égalité et l'équité d'accès aux soins les plus basiques ne sont pas forcément bien garanties. Il va falloir changer de paradigme. Ceci passera par des médecins mieux répartis, le développement des professions intermédiaires, du fonctionnements en équipe, etc.

Les biais de population, liés à l'origine des patients, sont l'un des biais les plus lourds. On vous amène un algorithme de l'autre côté de l'Atlantique : il a été testé sur une population de femmes américaines qui ne mangent pas la même chose que les femmes européennes, qui n'ont pas reçu les mêmes traitements, etc. Si nous voulons avoir des algorithmes pertinents, il va falloir recueillir des informations sur l'origine des patients qui ont alimenté la base de données ayant servi à les construire. C'est une décision importante. Il est très heureux que nous ayons un système de protection des données personnelles, mais il ne faut pas que cela devienne une espèce de ligne Maginot de l'accès aux données.

Vous trouviez que le projet de loi était « trop court » sur l'IA. Je suis entièrement d'accord. J'ai trouvé qu'il y avait une sorte de désinvolture sur ce sujet. De nombreuses questions devront être complétées par le décret d'application qui, lui, sera long. Sinon tout ce qu'aura fait la loi aura été de dire : « donnez une information au patient sur l'algorithme ». Le médecin n'a pas forcément cette information, il ne l'a pas forcément comprise et à la fin, il va devoir assumer la responsabilité de la décision. Je n'ai rien contre les responsabilités, j'ai passé ma vie à en assumer, j'ai été chef d'un service où exerçaient 80 médecins, mais je veux avoir les moyens de l'assumer. Et je trouve que cette garantie, en l'état, n'existe pas.

Pour finir, bien sûr, nous avons peur que les machines aillent beaucoup trop loin et qu'elles se mettent à faire des choses que nous n'attendions pas forcément. Je vous conseille la lecture du livre La Singularité n'existe pas écrit Jean-Gabriel Ganascia, qui est professeur d'intelligence artificielle à Sorbonne Université. Elle n'existe pas en l'état – n'oubliez pas qu'une voiture autonome, c'est de l'intelligence artificielle faible. Peut-être existera-t-elle dans trente, ou quarante, ou cinquante ans. Aujourd'hui nous sommes très loin de la singularité, c'est-à-dire l'IA qui va plus loin et plus vite que nous.

S'agissant de la définition de l'IA, elle est juste un élément du numérique et c'est le numérique qui nous environne globalement. Donc nous savons le définir. Dans le rapport co-écrit avec David Gruson, nous avons défini un certain nombre de domaines, allant des techniques d'apprentissage machine jusqu'aux techniques de résolution de contraintes, d'optimisation, et de modélisation du raisonnement. Tout cela fait partie de ce que nous appelons depuis plus de 50 ans, l'intelligence artificielle. En revanche, jusqu'où ce périmètre s'étend-il ? Un certain nombre d'algorithmes peuvent modifier leur comportement en acquérant de l'information sur ce qui se passe à l'extérieur. Nous l'expérimentons tous les jours : si un avion n'avait pas de capteurs, il ne volerait pas. L'humain construit des environnements en utilisant des capacités algorithmiques qu'il a développées, aussi bien au niveau des algorithmes eux-mêmes que des machines, de la communication, etc. Ce cadre crée le contexte d'évolutions extrêmement rapides, d'où l'importance de ne pas trop légiférer. Une législation trop stricte bloquerait le système et empêcherait la France d'innover. Cependant, cela ne signifie pas qu'il ne faut pas comprendre ce que nous sommes en train de faire en innovation : il faut se donner des institutions telles que le CCNE, les comités opérationnels d'éthique, les comités de protection des personnes, la HAS, etc., pour nous donner la capacité de comprendre dynamiquement comment nous avançons et pas seulement mettre des barrières. C'est nous qui sommes les concepteurs de ces systèmes et qui avons la capacité à les maîtriser. Mais nous n'avons pas toujours la capacité de le faire de façon souveraine parce que nous sommes dans un contexte international qui fait que l'humain va développer un certain nombre de capacités au niveau mondial, mais que les différentes cultures ou les différentes façons d'apprécier les moyens d'interagir entre ces systèmes d'information biologiques qui sont nous-mêmes – entre autres – et les systèmes d'information numérique ne sont pas les mêmes selon les différents pays. Le problème géopolitique, le problème de la souveraineté, ici, est fondamental.

Je réponds ainsi à votre question sur la complémentarité homme-machine. Imaginez qu'on ôte le numérique pendant cinq minutes de notre univers. Ce serait le chaos : il n'y aurait plus d'électricité, plus d'eau, etc. La complémentarité est extrêmement forte entre ces deux systèmes d'information, même si celui que nous avons construit a aujourd'hui une certaine autonomie au sens où il a pris une importance telle qu'il est difficile d'imaginer que nous puissions nous en passer.

Nous arrivons à faire des choses formidables autour de l'impression 3D : on peut prendre la photo en 3D d'un os cassé et le reconstruire assez facilement. Comment l'utilise-t-on dans la clinique et comment développe-t-on la recherche autour de cela ? Cela doit être supervisé, contrôlé, non pas par la loi, mais par des entités qui auront la capacité de mettre au point des régulations à partir du moment où nous considérerons que cela sera nécessaire.

Le travail autour de la transparence des algorithmes est fondamental : qu'est-ce qu'un algorithme ? Comment est-il construit ? Qui le construit ? Qui le maintient ? Quelle est sa vie globale ? Ce n'est pas propre à la santé : il n'y a qu'à voir ce qui se passe aujourd'hui chez Boeing. Ce type d'environnement algorithmique est très complexe et nous devons nous donner les moyens de mieux le maîtriser. C'est un sujet de recherche technique, mais cela relève aussi de notre capacité à porter un regard humain sur la façon dont nous mettons au point ces innovations, par exemple à travers des comités d'éthique. J'aime bien l'argument selon lequel l'éthique est un argument de compétitivité. Il faut que nous sachions valoriser cet argument dans le cadre du développement de l'innovation, en France et en Europe.

Pour ce qui concerne le consentement, l'importance croissante des données dans la décision médicale fait qu'il est peut-être éclairé mais peut-être aussi pas tout à fait libre. Aujourd'hui, je vais voir le docteur Uzan et je lui dis : « voilà, j'ai une maladie très grave. Est-ce que je dois vraiment vous donner toutes mes données parce que si vous ne les avez pas, vous ne pourrez pas établir un bon diagnostic ? » Lorsqu'on a besoin d'accéder à la médecine, la liberté du consentement ne va pas de soi. Or l'enjeu est bien plus important aujourd'hui, car les données que nous allons délivrer vont être diffusées de façon bien plus large que dans le cabinet d'un médecin. Comment arrive-t-on à maîtriser cela ? Cela relève, naturellement, d'une collaboration internationale, mais surtout de la façon dont nous souhaitons organiser le lien entre la dimension sanitaire et la dimension économique, avec toute l'innovation qui va derrière. Pour avancer sur la question du consentement, il faut se la reposer souvent et se donner la capacité d'auditer les systèmes, de les qualifier puis de les certifier, et, tout en amont, de décrire l'ensemble des propriétés que nous souhaitons leur donner, en particulier pour des systèmes médicaux, comme nous avons su le faire et comme nous savons le faire de mieux en mieux pour les systèmes aéronautiques. En matière de véhicule autonome, nous en sommes encore loin. Je rappelle qu'aujourd'hui, nous savons faire atterrir et décoller un avion sans intervention humaine directe. Il peut y avoir des erreurs humaines ou au niveau des logiciels mis en œuvre, mais les progrès que nous avons faits, en particulier en numérique, nous permettent à la fois de certifier une transparence – on comprend ce qu'il se passe – et d'auditer les choses. Un exemple intéressant est l'ANSSI : l'Agence nationale pour la sécurité des systèmes d'information a montré sa capacité à analyser un certain nombre de situations permettant de comprendre si tel ou tel système est cybersecure ou pas. C'est l'occasion de dire que dans les systèmes médicaux, il y a aussi des questions de cybersécurité qui sont difficiles, mais pour lesquelles il est intéressant de garder ces considérations présentes à l'esprit.

Je m'inscris complètement dans la lignée de ce qui a été dit. En me situant par rapport au texte que vous allez avoir à examiner, je vais partager avec vous une réflexion sur le rôle du Parlement sur ce sujet. Il est pour moi est fondamental, mais circonscrit, sur la partie production normative par rapport à ce qui existe déjà ; il est également fondamental, mais très étendu, sur ce qu'il faut développer en termes de contrôle et d'évaluation du développement de l'IA en santé.

Sur la partie production normative, j'ai déjà dit que le dispositif me semble équilibré. J'entendais des observations ou des questionnements. Si vous vouliez aller plus loin que le texte proposé pour ajouter un degré de protection, ou de sécurité supplémentaire – il faut bien en mesurer la portée, parce que chaque durcissement apporté à un texte à réduit la capacité d'innovation des acteurs de terrain – il conviendrait de rendre plus explicite le principe de garantie humaine en introduisant l'expression dans la loi car que dans le texte actuel, le principe est réduit à sa fonctionnalité. Le professeur Uzan parlait d'instruments réglementaires ou de textes d'application. La substance d'un texte d'application pourrait consister à demander au gouvernement d'encourager le développement dans le système de santé d'outils de garantie humaine de l'intelligence artificielle, dont le Parlement assure le suivi de la mise en œuvre à l'occasion d'un point annuel ou d'un rapport annuel qui lui serait présenté, permettant de regarder les conditions pratiques dans lesquelles le ministère de la Santé et le ministère de la Recherche encouragent les acteurs à déployer ces outils de supervision.

J'aborde ainsi le sujet de l'évaluation : il y aurait donc un rendez-vous annuel. Nous voyons bien que la bioéthique place la France dans une situation un peu pionnière dans la construction du cadre juridique de l'IA appliquée à la santé. Cela a ses avantages : ce qui a été construit dans la phase préparatoire se diffuse ailleurs. Cela a aussi ses limites : l'IA en santé se développe tellement rapidement que le rythme actuel de révision tous les sept ans de la loi de bioéthique est incommensurablement lent par rapport au rythme de déploiement de l'IA en santé. L'idée n'est pas forcément d'avoir un rendez-vous législatif tous les ans, mais un point d'évaluation sur les conditions de mise en œuvre du principe de garantie humaine. Y a-t-il des collèges de garantie humaine ? Les outils de formation se développent-ils ? Le ministère met-il les moyens permettant de développer des programmes de recherche sur la supervision de l'IA en santé ? Ce serait un réel apport par rapport à la rédaction actuelle du texte.

Je voudrais répondre à la question relative à la structure susceptible d'exercer le contrôle : l'IA en santé me paraît entrer clairement dans le périmètre de la HAS, quitte à ce qu'elle confie le sujet à une section spécifique.

C'est d'autant plus son rôle que la loi le prévoit ainsi, le CCNE intervenant sur la partie éthique et l'Ordre des médecins dans ses attributions. J'évoquais tout à l'heure la décision de la Cour de justice de l'Union européenne sur les logiciels d'aide à la prescription. La CJUE a aussi défini l'office de la HAS et du législateur national en disant qu'aucun régime national d'autorisation préalable d'un dispositif médical ne peut venir en complément du marquage CE. À mon avis, cette jurisprudence peut sans doute être étendue au cas de la certification des algorithmes de diagnostic médical, interdisant la mise en place d'un dispositif national. La France devrait sans doute avoir une présence plus forte dans les instances d'élaboration du droit européen, mais la décision de la CJUE de décembre 2017 clarifie l'office du législateur national sur cette question.

Je ne sais pas si nous serons présents dans sept ans pour parler d'intelligence artificielle, mais peut-être nous retrouverons nous si la révision devenait annuelle ! Merci, messieurs, merci à mes collègues.

L'audition s'achève à dix-neuf heures cinquante.

Membres présents ou excusés

Commission spéciale chargée d'examiner le projet de loi relatif à la bioéthique

Réunion du mercredi 4 septembre à 18 heures 30

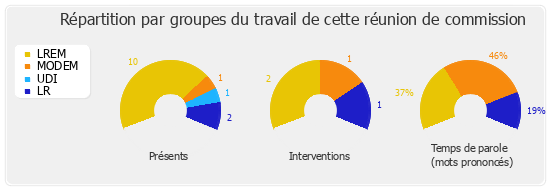

Présents. - Mme Anne-France Brunet, M. Francis Chouat, Mme Agnès Firmin Le Bodo, M. Guillaume Gouffier-Cha, M. Brahim Hammouche, Mme Monique Limon, M. Maxime Minot, Mme Bénédicte Pételle, M. Jean-Pierre Pont, Mme Florence Provendier, M. Pierre-Alain Raphan, Mme Laëtitia Romeiro Dias, M. Jean-Louis Touraine