Office parlementaire d'évaluation des choix scientifiques et technologiques

Réunion du jeudi 14 février 2019 à 9h40

La réunion

Jeudi 14 février 2019

Présidence de M. Gérard Longuet, sénateur, président de l'Office

La séance est ouverte à 9 h 40

Audition, ouverte à la presse, du Professeur Gérard Mourou, prix Nobel de physique 2018

– Chers collègues membres de l'Office parlementaire d'évaluation des choix scientifiques et technologiques (OPECST), j'ai l'honneur de vous accueillir dans cette salle qui est habituellement celle de la commission des finances du Sénat, ce qui me permet d'accomplir l'un de mes voeux secrets, celui de présider cette commission, mais aujourd'hui tel n'est pas le cas. Je remercie ceux qui ont pu se libérer pour une matinée d'un très haut niveau intellectuel puisque nous avons la chance d'entendre Gérard Mourou, prix Nobel de physique 2018. Gérard Mourou est le quatorzième prix Nobel de physique français depuis 1903, année où Pierre et Marie Curie et Henri Becquerel l'obtenaient pour la première fois. Je souhaite également la bienvenue au Professeur Sydney Galès, directeur de recherche émérite à l'Institut de physique de l'Université de Paris-Orsay.

J'ai souhaité que le Professeur Gérard Mourou nous présente ses travaux, non seulement parce qu'il a reçu le prix Nobel de physique mais également parce qu'il dirige à l'École Polytechnique le laboratoire d'optique appliquée et y mène des travaux sur l'application de lasers ultra rapides et très puissants. Les applications de ces recherches sont nombreuses et ont déjà trouvé des débouchés comme celui de la chirurgie de l'oeil. Vous avez été distingué pour ces travaux dans une dimension totalement internationale - ce qui est d'ailleurs rassurant car cela prouve l'unité mondiale de la communauté scientifique - avec un Américain, Monsieur Arthur Ashkin, et une Canadienne, Madame Donna Strickland. Avec celle-ci vous avez mis au point des méthodes de production d'impulsions lumineuses ultra-brèves et de forte intensité.

Professeur Mourou, vous dirigez à Saclay et avez contribué à la réalisation de l'Institut de Lumière Extrême (ELI). À ce titre vous avez obtenu que soit installé le laser Apollon, le plus puissant du monde, dédié à la lumière extrême, qui sera bientôt opérationnel. Vous avez également été à l'initiative et supervisez dans un cadre européen la mise en oeuvre d'autres grandes installations dédiées à la lumière extrême.

Dans vos prises de position, cher Gérard Mourou, j'ai été passionné par deux sujets très précis. Le premier concerne le nettoyage des débris spatiaux, qui semble être un problème majeur sur lequel Catherine Procaccia, sénateur du Val-de-Marne et Bruno Sido, sénateur de la Haute-Marne, ont travaillé. Le deuxième sujet d'application du laser, qui me passionne à titre personnel et devrait passionner également tous les Français, est celui de la transmutation des déchets nucléaires pour accélérer d'une façon spectaculaire la fin de leur nocivité.

Nous souhaitons exprimer la fierté d'avoir de nouveau un prix Nobel de physique français. Nous tenons également à vous dire que les sujets sur lesquels vous travaillez méritent toute notre attention, et que les applications de cet outil laser sont au coeur des préoccupations publiques de nos deux assemblées. En réalité, ne pouvant parler pour l'Assemblée nationale, je laisserai Cédric Villani s'exprimer pour cette dernière, comme sur tous les sujets qu'il souhaite.

– Merci cher Gérard, Monsieur le Président. Je n'ai rien à ajouter, si ce n'est que l'Assemblée nationale associée à l'OPECST, organe bicaméral, se réjouit considérablement de la venue de Gérard Mourou. Comme Gérard Longuet l'a souligné, Monsieur Mourou s'inscrit dans une longue lignée de physiciens français couronnés dont nous sommes fiers, et dans ce domaine de la physique nucléaire tout particulièrement. J'ai eu l'occasion de côtoyer à plusieurs reprises Claude Cohen-Tannoudji et Serge Haroche. À chaque fois, ces Nobel ont marqué des étapes très importantes du point de vue de la technologie, de la science et du rayonnement de la France. Avec Gérard Mourou, nous avons aussi une distinction marquante, aussi bien sur le fond que sur la forme.

Gérard Mourou me rappelait il y a quelques instants que nous étions invités l'un et l'autre sous la coupole de l'Académie des sciences il y a une douzaine d'années pour recevoir des prix scientifiques. Depuis lors, lui comme moi avons eu la chance de nous retrouver face à des prix beaucoup plus visibles. Comme chacun le sait, ce n'est pas tout d'obtenir des prix, il convient aussi de savoir ce que l'on en fait. Il s'agit dès lors de valoriser le capital de lumière que ces prix représentent. Dans le cas de Gérard Mourou, nous verrons que les applications fondamentales - dans tous les sens du terme - laissent augurer d'un avenir considérable.

– Merci beaucoup de cette invitation à venir m'exprimer devant vous, reçue avec mon ami le Professeur Sydney Galès. Merci pour tous les éloges que vous nous avez adressés. Il n'est en effet pas tout de gagner un prix prestigieux, il faut ensuite savoir ce que nous allons en faire. Ce prix nous confère immédiatement une aura extraordinaire, qui facilite nos rêves et la réalisation de nos missions. Le domaine pour lequel j'ai été distingué est celui des lasers à très haute intensité, qui permettent de façon pratique de réaliser beaucoup de choses.

Une autre personne dont je parlerai dans ma présentation est le Professeur Toshiki Tajima, de l'Université d'Irvine (UCI) en Californie, qui n'a malheureusement pas pu se joindre à nous. De même que je suis le spécialiste du laser à haute intensité, le professeur Tajima est l'inventeur de l'une des grandes applications de ce laser : la Laser Wakefield Acceleration (LWFA) qui permet d'utiliser un laser pour accélérer des particules. Ce concept est extrêmement important pour la transmutation des déchets, car il s'agit avant tout de créer des particules à très haute énergie. En mixant l'invention du professeur Tajima et la mienne, il est possible de créer de très fortes intensités et de réduire d'une façon considérable la taille des accélérateurs. Cette taille passerait ainsi de plusieurs centaines de mètres, voire dizaine de kilomètres actuellement pour les accélérateurs conventionnels, à une échelle de l'ordre du centimètre !

Lorsque j'ai reçu le prix Nobel, j'ai indiqué que l'un des domaines dans lesquels je souhaitais m'investir – pas nécessairement tout de suite – était le développement de ce laser à très haute intensité. J'ai invité aujourd'hui le professeur Sydney Galès, car il est une sommité dans le domaine du nucléaire et nous travaillons tous deux avec le professeur Tajima. Nous aurons un débat intéressant aujourd'hui. La transmutation des déchets nucléaires pourrait peut-être être réglée avec cette arme nouvelle qu'est le laser de haute intensité.

Monsieur le Président, vous avez évoqué les débris spatiaux : je n'en parlerai pas principalement aujourd'hui, mais c'est ma deuxième passion.

– Je suis néanmoins convaincu que des questions vous seront posées sur ce sujet à l'occasion du débat.

– J'ai obtenu le prix Nobel en association avec Donna Strickland, ce dont je suis très fier car elle était mon étudiante. Donna est la troisième femme à avoir obtenu le prix Nobel de physique, alors que moi je suis l'un des deux-centièmes prix Nobel. J'en suis très fier car j'ai été son tuteur et son professeur. Je ne crois pas qu'un autre scientifique ait vu l'un de ses étudiants obtenir ce prix. Le rôle des femmes en physique est très important, et je me suis toujours efforcé de travailler avec elles. Je suis heureux d'avoir joué un rôle dans le prix Nobel de Donna Strickland.

– On se souvient de la controverse historique sur le rôle de Lise Meitner dans l'obtention du prix Nobel par Otto Hahn. Heureusement, les temps changent, et le comité Nobel n'a plus le réflexe de considérer que seuls les hommes méritent récompense.

– Tout à fait.

Je vous propose d'évoquer maintenant le concept qui nous permet d'obtenir, avec des lasers, des puissances considérables. Nous parlons de puissances de l'ordre du Pétawatt. Le Pétawatt (PW) équivaut à 1 000 fois la puissance de la grille mondiale électrique, c'est-à-dire la somme de toutes les unités produisant de l'électricité dans le monde, représentant quelques Térawatts. Bien sûr, nous trichons un peu, car le Térawatt de la grille est constant alors que notre Pétawatt dure quelques femtosecondes, soit un milliardième de millionième de seconde. Pendant un temps si court, la lumière ne se déplace seulement que de quelques microns. C'est donc extrêmement rapide. Cette astuce nous permet d'obtenir des puissances considérables, puisque la puissance est l'énergie divisée par le temps. Même avec une énergie modeste de quelques joules, nous délivrons cette énergie en quelques femtosecondes, ce qui permet d'obtenir des puissances immenses.

Pour produire cette grande puissance, nous avons dû trouver un stratagème. C'est la Chirped Pulse Amplification (technique dite CPA), qui a permis d'extraire l'énergie dans le matériau laser de façon très satisfaisante, et pendant des temps très brefs. Auparavant, nous étions limités à des puissances un million de fois plus faibles. Cette avancée a donc représenté un bond gigantesque, initié par Donna et moi-même en 1985. Avec le laser, il est possible de focaliser cette puissance sur quelques microns, et donc d'obtenir des pressions de radiation absolument considérables, correspondant au poids de millions de Tour Eiffel sur l'équivalent de la surface d'un doigt.

La lumière extrême fournit les intensités les plus élevées, les champs électriques les plus grands, les pressions les plus importantes, les accélérations les plus rapides et les températures les plus élevées. Elle est une source universelle de particules et de radiations de haute énergie.

Le CPA est désormais utilisé partout dans le monde pour produire des impulsions de très grande puissance. Je suis très heureux, cependant, que ces lasers de grande puissance ne soient pas utilisables à des fins militaires. En effet, les impulsions sont extrêmement brèves, alors que les militaires sont intéressés par des impulsions de longue durée. Nous produisons beaucoup d'énergie, mais elle est délivrée en un temps très bref. C'est la raison pour laquelle le domaine de la lumière extrême a rencontré l'engouement immédiat des universités.

Le laser a été inventé par Charles Townes, et démontré le 16 mai 1960. Très rapidement, des puissances assez élevées ont été obtenues, avant de constater, à partir de 1965, que l'on rencontrait un plateau. Les puissances de l'époque permettaient notamment l'ablation de matériaux. En 1985, avec l'apparition du CPA, la puissance a pu croître de façon significative pour passer à des zones nouvelles de la physique, où l'interaction laser-matière change profondément. La zone qui nous intéresse, correspondant à l'accélération des particules, est jaune sur le schéma projeté (cf. annexe). Nous souhaitons aller encore plus loin, vers un domaine où la lumière interagit avec le vide. Je suis persuadé que nous atteindrons ces intensités encore plus élevées dans quelques années, et que nous pourrons jouer un rôle important dans le domaine de la physique des particules. Toutefois, un certain nombre de questions ne sont toujours pas résolues, notamment celle de savoir comment la lumière se propage dans le vide.

Toujours est-il qu'en 1985, avec Donna Strickland, nous avons donc démontré le concept de CPA. Précédemment, en 1979, Toshiki Tajima avait inventé un concept pour l'accélération de particules, nécessitant de disposer d'intensités très élevées. Son invention est demeurée inutilisée jusqu'à la fin des années 1980, lorsque le Naval Research Laboratory de Washington a réuni mon concept et celui de Tajima. Ainsi a démarré le domaine de l'accélération des particules par laser, qui s'est considérablement étendu aujourd'hui.

Je présente ici un jet de gaz banal (de l'ordre de quelques millimètres de diamètre), sur lequel est focalisé le laser ultra-intense. Le gaz sera ionisé, en séparant les ions et les électrons. Avec la pression de radiation, une onde plasma sera ainsi créée, sur laquelle les électrons pourront « surfer ». De ce fait, sur des petites distances de l'ordre du centimètre, les particules seront accélérées au niveau d'énergie de l'ordre du GeV (giga électronvolt). Pour donner un ordre de grandeur, le synchrotron SOLEIL est un anneau de 354 mètres, dont les particules se déplacent à 3 GeV. Pour nous, il faut seulement quelques centimètres pour atteindre ces mêmes 3 GeV.

Avec Toshiki Tajima et Sydney Galès, nous travaillons encore sur ces concepts, afin d'aboutir à l'accélération de particules dans les solides. Dans ce domaine, les perspectives pourraient produire le TeV sur un centimètre. Par conséquent, les perspectives sont immenses. Je n'en parlerai cependant pas plus avant, pour me cantonner aujourd'hui au GeV, niveau d'énergie des accélérateurs de bonne taille.

Il est possible d'accélérer toutes les particules de façon très efficace sur de petites dimensions. Ces particules pourraient ainsi être produites avec un laser relativement compact. Dans le domaine de la médecine, les applications pourraient concerner la proton-thérapie, qui constitue aujourd'hui l'une des thérapies les plus prometteuses et avancées, mais encore trop onéreuse du fait de la taille des installations qu'elle nécessite. Avec le laser, il serait possible de produire des protons sur des dimensions convenables, en réduisant substantiellement les coûts et en permettant de multiplier les installations.

En pharmacologie, les bénéfices seraient également immenses. En effet, les isotopes pourraient par exemple être produits sur place, à l'hôpital, au lieu de l'être dans un réacteur à des kilomètres de distance. Le rêve serait même de produire ces matériaux au chevet du patient.

Dans le domaine qui nous intéresse, la possibilité d'utiliser les lasers et de produire les particules pour la transmutation des déchets représenterait également un pas très important pour l'humanité.

Un diagramme est projeté (cf. annexe).

– Sur l'échelle verticale, le diagramme montre la radio-toxicité et sur l'échelle horizontale, la durée de vie des déchets. La courbe la plus haute est celle qui consiste à brûler de l'uranium pour produire de l'énergie nucléaire et de l'électricité, en laissant les déchets se désintégrer au rythme lent de l'ordre de plusieurs centaines de milliers d'années.

– J'observe que les deux axes sont en coordonnées logarithmiques, de sorte que chaque unité est en décade et qu'elle est multipliée par dix d'une unité à la suivante.

– En effet, chaque unité représente une décade de décroissance, soit un facteur dix.

Nous ne considérons pas que l'ensemble des déchets soient réellement qualifiables ainsi. Par exemple, le plutonium est fertile : mélangé à l'uranium pour produire du combustible, il peut être brûlé à nouveau. La deuxième courbe décrit cette production de « fuel ». Nous arrivons donc à réutiliser une partie de nos déchets. Cette équation apparaît raisonnable à la fois sur le plan technique et économique.

La situation est autre dans le domaine de la transmutation. Environ 50 kilogrammes d'actinides sont présents dans ces déchets, qui sont les produits les plus radiotoxiques et produisant le plus de chaleur. Cette chaleur emmagasinée occasionne un grand nombre de difficultés, lorsqu'on s'attache à l'idée d'un stockage profond.

La troisième courbe, qui descend le plus rapidement, croise une échelle horizontale. C'est la radio-toxicité naturelle de l'uranium dans la mine, au moment où il est extrait. Notre ambition est d'obtenir que les déchets reviennent à l'état naturel de la mine, sans ajout particulier. C'est le but de la transmutation. Lorsque nous y parviendrons, nous pourrons considérer que nos déchets sont correctement gérés pour les générations futures.

– Elle sera plutôt à l'échelle de trois cents années. Mais cela signifie que le volume de ces déchets radiotoxiques est réduit d'un facteur 1 000, tandis que leur durée de vie est diminuée drastiquement, passant de plusieurs dizaines de milliers d'années à trois cents ans. À l'échelle de temps de l'humanité, cela apparaît raisonnablement contrôlable. Tel est le grand enjeu de la transmutation.

– Pour réaliser cette transmutation, nous devons produire des neutrons de différentes façons, avec des lasers de très haute intensité.

Le schéma « Concept de transmutation nucléaire » est projeté (cf. annexe).

Dans ce schéma, apparaît un neutron produit. Le neutron se retrouve ensuite projeté dans le noyau de l'atome (le noyau est entouré d'un nuage d'électrons), pour casser ce noyau et en créer deux nouveaux. La fracture du noyau s'accompagnera d'émissions d'ions. Ici, les deux noyaux ont des temps de demi-vie de l'ordre de quatre à quinze minutes. Le noyau d'origine est le neptunium, dont le temps de demi-vie est de deux millions d'années. Après fracture, les deux nouveaux noyaux connaîtront des temps de vie très courts, après lesquels ils deviendront stables. Telle est l'avancée que nous souhaiterions absolument réaliser.

– Le neptunium est l'un des déchets les plus radiotoxiques dans le fuel.

Ce schéma de fission a lieu tous les jours pour produire de l'énergie. Restent ces actinides de longue durée, très radiotoxiques mais ne représentant que cinquante kilogrammes par tonne. Ce sont eux que nous souhaiterions transmuter efficacement, pour un coût économique raisonnable. C'est un nouveau paradigme.

– La transmutation n'est pas un phénomène nouveau, elle a été testée avec le projet MYRRHA. Jusqu'à présent, cette opération nécessitait des systèmes énormes, de 400 mètres de long. Le rêve serait de remplacer ces systèmes avec des lasers beaucoup plus légers tels que le laser X-CAN, développé à l'École Polytechnique. Ces nouveaux systèmes doivent être efficaces, tout en produisant des inductions très intenses. Il est également nécessaire d'obtenir une puissance moyenne de l'ordre du mégawatt. Pour ce faire, nous devrons résoudre des difficultés persistantes, tel que le problème d'échauffement. Nous étudions ce sujet actuellement et nous avons des pistes sérieuses.

En conclusion, la lumière extrême offre des possibilités considérables à la recherche et à l'innovation, mais également à l'industrie française et européenne. Je suis rentré des États-Unis il y a environ quinze ans et j'ai alors commencé à proposer ce thème de recherche sur la lumière extrême. J'ai également soumis le sujet à la région Île-de-France avec le projet Apollon, et initié l'infrastructure européenne Extreme Light Infrastructure (ELI), dont les piliers se trouvent à Prague, Bucarest et à Szeged (Hongrie). Le laser Apollon de 10 pétawatts sera le plus puissant du monde. Les derniers essais sont en cours. Ces grands projets de lumière extrême sont une chance pour l'industrie française, car ils sont fabriqués par Thalès et Amplitude.

– Thalès est actuellement l'un des leaders mondiaux du domaine.

– Ce domaine de recherche représente des avancées considérables sur le plan scientifique, mais aussi sur le plan sociétal. Je suis très heureux qu'avec le CNRS et la Commission européenne, nous ayons pu réaliser les projets ELI et Apollon et contribuer à l'unification de la science dans les pays émergents et dans l'Union européenne.

– Pourrions-nous évoquer maintenant le sujet des débris spatiaux ?

– En 2012, Bruno Sido et moi-même avons publié un rapport sur la politique spatiale européenne. Nous avions, à cette occasion, évoqué le sujet des débris spatiaux, qui ne semblait pas du tout passionner la communauté spatiale à l'époque. Nous avions proposé un mode de financement pour la recherche, en soulignant qu'un organisme mondial percevant des fonds liés aux orbites, pourrait permettre de faire avancer la recherche sur ce thème. Depuis lors, un certain nombre de pays ont développé des projets, mais nous n'en connaissons pas le stade d'avancement. Votre technique, si elle voyait le jour, permettrait d'obtenir un système de laser embarqué de très petite taille quel que soit le système porteur. Dans ce cas, les débris seraient-ils entièrement détruits ?

– Effectivement, le sujet des débris est important même si le danger n'est pas immédiat. Néanmoins, au rythme auquel sont lancés les satellites, nous nous attendons à une accélération du problème. En 2017, les Russes ont fêté à Moscou les soixante ans de Spoutnik, anniversaire auquel j'étais invité. À cette occasion, j'ai rappelé que nous avions envoyé dans l'espace l'équivalent de trois Tour Eiffel depuis soixante ans, ce que d'ailleurs personne ne conteste. Nous avons ainsi produit des déchets de toutes tailles, allant de celle d'une machine à laver au centimètre. Pour notre part, nous pourrions traiter les débris de l'ordre du centimètre. Les débris se déplacent à dix fois la vitesse des balles les plus rapides. Le concept que nous proposons vise, après détection d'un débris, à créer une ablation de ce débris avec le laser. Cette ablation s'accompagnerait d'un « effet fusée », pour changer l'orbite du débris. Après un certain temps, le débris entrerait dans l'atmosphère pour s'autodétruire.

Une autre approche consisterait à localiser précisément les débris de l'ordre du centimètre, alors que seuls les gros débris sont identifiés actuellement. Aujourd'hui, la localisation des débris est effectuée avec une précision médiocre, de l'ordre de quelques centaines de mètres. En raison de cette imprécision et pour ne prendre aucun risque, il est constamment nécessaire de changer les satellites d'orbite. Pour autant, les fausses alertes sont extrêmement nombreuses, de l'ordre du million. Après analyse, ces alertes sont ramenées à une dizaine par an. Il s'agit d'un gros problème, car le changement d'orbite consomme beaucoup de temps et d'énergie. À l'inverse, une meilleure identification des débris constituerait une avancée certaine.

– Serait-il envisageable d'équiper tous les satellites d'un détecteur ?

– Nous n'en sommes pas encore là car le système est encore quelque peu encombrant. Néanmoins, il pourrait s'agir d'une avancée importante pour la France. Si j'avais su que nous allions évoquer le sujet des débris, je vous aurais exposé la présentation qui leur est dédiée. Je suis tout à fait disposé à revenir parmi vous pour une nouvelle réunion sur ce sujet, qui me tient particulièrement à coeur. Finalement, la problématique est toujours la même : il faut mettre au point un laser efficace et de petite taille.

– Le rêve ne serait-il pas de mettre au point un système suffisamment petit pour équiper les satellites, afin qu'ils puissent détruire les débris ?

– Le système consiste à réaliser l'ablation du débris, c'est-à-dire à le transformer en gaz. Cette opération s'accompagne d'une poussée, que nous souhaitons utiliser pour dé-orbiter le débris.

– Ils se situent à environ 800 kilomètres de la Terre.

– En réalité, en faisant se vaporiser une face du débris, on crée une poussée, une asymétrie. C'est bien cela ?

– Exactement. Il y a un effet de recul, comme avec un ballon, avec le principe de conservation du moment cinétique. L'ablation est une perte de matière.

– Plus exactement, c'est une perte de matière à une certaine vitesse. La matière sera perdue à une vitesse de quelques centaines de mètres par seconde. Personnellement, il m'apparaîtrait indiqué de réaliser une cartographie des petits débris de moins de dix centimètres, sachant que les gros sont d'ores et déjà identifiés.

– Lors de notre mission aux États-Unis en 2012, nous avons appris que les Américains possédaient déjà plusieurs radars assez précis, leur permettant de localiser les débris de dix centimètres. Nous n'en savons pas davantage. En ce qui concerne la France, elle possède un radar dénommé GRAVES, en cours de modernisation, mais qui ne regardera pas grand-chose car il reste au-dessus de nous. Au contraire, les Américains connaissent les débris présents tout autour de la Terre, mais nous ignorons jusqu'à quelle taille ils sont en mesure de les identifier. Il existe cependant une bonne coopération entre nous.

– Le sujet des débris entraîne également un problème juridique : dans l'espace, seul ce qui nous appartient peut être détruit.

– Il est invraisemblable de considérer qu'il existe un droit de propriété sur un débris d'un centimètre.

– Nous y avons pensé. Je vous montrerai, dans une future présentation, qu'il est possible d'identifier la forme du débris ainsi que la composition des matériaux, dans la perspective de déterminer leur propriétaire.

– Monsieur le Professeur, merci beaucoup pour cet espoir que vous nous donnez. Je souhaite savoir si l'accélérateur laser pourrait être développé pour l'hôpital ou un centre de radiothérapie, par exemple à titre expérimental. Comment un hôpital pourrait-il y accéder ?

– Il s'agit de l'un de mes thèmes de recherche actuels sur la lumière extrême. L'objectif est de pouvoir développer des systèmes de protons avec une énergie de 200 à 300 MeV.

Je laisse Sydney Galès expliquer pourquoi la radiothérapie par proton est très intéressante par rapport aux électrons et aux rayons X.

– À Orsay, j'ai fait ma thèse sur un accélérateur de protons construit par Joliot-Curie en 1956. En 1993, cet accélérateur de protons de 200 MeV a été confié pour un franc symbolique à l'hôpital Curie. Aujourd'hui, c'est un centre de proton-thérapie traitant des milliers de patients atteints de cancer. Cet ensemble mesure quelques centaines de mètres carrés au sol, mais a été créé à partir de la recherche fondamentale pour un franc symbolique. Ces protons de 200 MeV ont la bonne énergie pour traverser l'ensemble du corps, quelle que soit la localisation de la tumeur. Ces particules déposent leur énergie à l'endroit qui correspond à leur énergie finale, à la différence des rayons X ou des rayons Gamma, qui déposent leur énergie depuis l'entrée dans le corps jusqu'à la tumeur. Ce faisant, ils créent des effets secondaires inutiles, que nous savons aujourd'hui combattre.

En France, deux centres de proton-thérapie sont installés, l'un à Orsay, l'autre à Nice. Un centre de carbone-thérapie est en cours de création à Caen. Cette technologie est encore meilleure que la proton-thérapie, car les noyaux de carbone sont plus efficaces pour détruire les cellules cancéreuses qu'un proton. Les machines de proton-thérapie de 200 MeV sont aujourd'hui fabriquées par IBA, une firme belge créée par un physicien, et vendues pour environ 40 à 50 millions d'euros. Ces machines d'une taille immense, représentent actuellement le nec plus ultra de la technologie. L'impact, dans le futur, des possibilités évoquées par Gérard Mourou, améliorera ces systèmes en coût, en surface et en gestion. Encore faut-il que nous parvenions à fabriquer un prototype, et que nous le démontrions.

Pour répondre à votre question, nous voyons en effet un avenir pour cette technique à l'hôpital. En tout état de cause, pour guider les particules à l'endroit de la tumeur, il est nécessaire de les placer, au sortir de l'accélérateur, dans des énormes ensembles magnétiques pour les orienter en angle et en précision. Ces ensembles magnétiques sont très lourds à régler du point de vue mécanique. C'est pourquoi l'approche laser à partir de la lumière serait beaucoup plus simple et moins coûteuse.

– Je souhaite à mon tour féliciter le professeur Mourou et le professeur Galès pour leur présentation et pour la pédagogie dont ils font preuve, qui rendent accessibles ces notions physiques, compliquées même pour un « matheux » comme moi. Ce travail de pédagogie pourrait être transmis à l'ensemble de la population, à commencer par les ministères et une partie des parlementaires, qui expriment une préoccupation pour l'avenir de la filière nucléaire. Votre message est réellement porteur d'espoir et d'amélioration de l'efficacité de la filière nucléaire, dont nous connaissons l'importance pour notre pays.

Alors que nous sommes actuellement mobilisés sur des considérations de bilan carbone, pouvez-vous nous en dire plus sur les délais d'aboutissement de vos travaux à l'échelon industriel, sur la réduction du volume de stockage et de durée de vie des déchets nucléaires ? Ce processus nécessite également de la production d'énergie. Quel en est le bilan carbone ?

– Je compléterai ensuite la question de Stéphane Piednoir.

– Le CEA, questionné sur le sujet, nous a informés que vous aviez tenu deux réunions de travail avec lui en septembre et décembre derniers sur les transmutateurs. Le communiqué du CEA, prudent, reconnaît « le caractère très innovant du projet franco-américain auquel contribue Gérard Mourou, mais a soulevé des questions importantes qu'il convient d'étudier en priorité, car la faisabilité et les performances de cette machine en dépendent. Leur assemblage dans une même machine des technologies considérées, suscite de nombreux problèmes scientifiques et techniques, qui doivent être davantage justifiés ».

Avez-vous un commentaire sur ces entretiens au CEA et les suites envisagées ? Évidemment, quel que soit le projet de recherche, il demande à être démontré. Ce n'est pas étonnant en soi.

– Je vais alléger ma question, dont une partie reprenait les observations du CEA telles que rapportées par notre collègue député Julien Aubert, qui s'est impliqué sur le sujet.

Bruno Sido et moi-même sommes les sénateurs des deux départements français, Haute-Marne et Meuse, ayant accepté le stockage en couches géologiques profondes des déchets nucléaires à forte activité et vie longue. J'ai été le ministre de l'industrie ayant dû mettre en oeuvre la loi de décembre 1991 défendue par notre collègue Bataille, ancien membre de l'OPECST, texte qui pour la première fois s'attaquait de façon sérieuse à la question des déchets nucléaires dans notre pays. J'ouvre une parenthèse pour dire qu'à cette époque, j'avais été très étonné, en tant que ministre, de découvrir que nous avions équipé le pays de cinquante-huit réacteurs nucléaires mais que nous n'avions pas sérieusement géré le sujet des déchets à forte activité qui en sortaient.

Nous acceptons ce stockage parce que la loi de 1991, intelligemment, proposait d'explorer trois filières parallèles : le stockage en couches géologiques profondes, l'entreposage sur les sites de production, et la transmutation reposant à l'époque sur les réacteurs Phénix et Super-Phénix. Quelle est la différence profonde entre la transmutation telle que vous l'imaginez, utilisant le laser à très brève et forte intensité lumineuse, et celle qu'imaginaient la filière française de l'électronucléaire et le CEA ? De mémoire, Phénix et Super-Phénix sont en maîtrise d'ouvrage CEA. Quelle est la différence en science fondamentale entre ces différentes voies ? Nous avons le sentiment que le CEA est quelque peu chagrin de ne pas avoir été à l'origine de cette nouvelle solution.

– Nous avons eu le plaisir, les 5 septembre et le 17 décembre 2018, de rencontrer le CEA. Notre prochaine réunion est fixée au 25 mars. J'invite d'ailleurs tous les membres de cet Office à y participer. À ces premières réunions, le CEA était majoritaire, mais était également présent le CNRS.

– L'ANDRA était absent. Est-ce l'organisme qui gère l'enfouissement ?

– Je peux vous communiquer le compte rendu de ces réunions, dont j'ai réalisé quelques copies.

– Je pense que la différence entre la pratique antérieure et celle que nous proposons aujourd'hui n'est pas grande. Le changement de paradigme provient de la façon nouvelle dont nous produisons les particules pour traiter les débris. La taille, le coût et l'efficacité sont également des facteurs différenciants, de même que la possibilité de traiter les déchets sur place.

– Le sujet du transport des déchets nucléaires d'un territoire à un autre, qui est toujours épineux, pourrait en effet être résolu.

– En préalable, je pense qu'il n'est pas bon que nous mettions en concurrence sur ce sujet différentes approches, en minimisant le rôle de l'une par rapport à l'autre. Bien évidemment, il faut optimiser les ressources de la nation, et il apparaît impossible de remplacer du jour au lendemain cinquante ans d'expérience sur les réacteurs nucléaires. Les réacteurs Phénix et Super-Phénix, à neutrons rapides, peuvent brûler les déchets. Pour autant, la communauté scientifique, dans son ensemble, n'imagine pas qu'il est possible de brûler les déchets dans un réacteur tout en produisant de l'énergie. Il est en outre généralement admis que la transmutation des déchets par production de particules, dans un prototype de type MYRRHA, actuellement en construction, est plus efficace, de l'ordre de 30 à 40 %. Le schéma de la transmutation a été poursuivi, car il comportait des avantages. En outre, il faut considérer qu'en France nous possédons cinquante-huit réacteurs, mais qu'il est inenvisageable de construire un transmutateur pour chacun. Dans les scénarios, la transmutation par accélérateur est vue comme une addition à un site de production d'énergie nucléaire, tous les dix réacteurs. L'optimisation est de cet ordre d'idée. Par ailleurs, je ne connais pas le prix d'un réacteur Super-Phénix, mais je sais que le projet MYRRHA est chiffré à deux milliards d'euros environ. Nous pensons, le professeur Mourou, le professeur Tajima et moi-même, que les idées innovantes, ne sont pas en compétition frontale. Ce serait en effet une erreur d'abandonner en cours de route des prospectives qui présenteraient un intérêt évident à être étudiées jusqu'au prototype.

– C'est l'autorité de sûreté nucléaire belge, dont je connais personnellement très bien le chef de projet, avec une collaboration internationale.

– Pour information, à l'occasion de la table ronde que nous avions tenue il y a quelques mois sur les nouvelles tendances de la recherche dans l'énergie nucléaire, celle représentée par notre collègue Jean-Claude Le Scornet était présente, et notre collègue avait fait une intervention haute en couleurs.

– Je peux l'imaginer.

– Sur ces questions de puissance des lasers, nous avons vu le graphique présentant l'historique depuis les années 1960, avec un palier dans les années 1970-1980 et un redémarrage ensuite grâce à vos travaux. Il y a donc une croissance exponentielle de la puissance. Y a-t-il une raison particulière à cette croissance exponentielle ?

– La croissance est essentiellement due à la tenue des matériaux laser, qui tiennent difficilement un flux de plus d'un joule par centimètre carré. Pour aller très haut en puissance et énergie, il faut disposer de composants adéquats. Par exemple, nous utilisons les réseaux de diffraction pour la compression, qui ont désormais des tailles de l'ordre du mètre carré.

En tout état de cause, nous parlons de la puissance crête. La puissance moyenne, c'est-à-dire le nombre de tirs par seconde, est limitée par la chaleur et les problèmes thermiques. Les pertes viennent des changements d'énergie et du gap quantique. En conséquence, nous sommes contraints d'utiliser des architectures différentes, basées sur la fibre optique de façon à avoir, pour un certain volume, le maximum de surface. Je pense que nous devrions pouvoir résoudre facilement ces problèmes techniques.

Par ailleurs pour répondre à la question sur les délais, selon moi il sera nécessaire de compter entre quinze et vingt ans.

– Émilie Cariou, retenue dans l'hémicycle, avait une question à poser sur les applications en stockage profond, la poursuite des différentes expériences en cours dans ce domaine et sur les délais. Vous y avez répondu dans vos développements.

– Monsieur le Professeur, cher Gérard Mourou, cher Sydney Galès, nous vous remercions très vivement, tous deux, de votre participation et de vos réponses. Je forme le voeu que l'Office parlementaire puisse établir un véritable suivi de ces échanges. Vous en mesurez en effet l'importance du point de vue politique, au sens de la vie de la cité. Je suis très sensible à la dimension internationale de vos travaux, qui est très rassurante pour de simples citoyens français confrontés à la gestion des déchets. Il est rassurant que les plus brillants esprits mondiaux réfléchissent ensemble.

En second lieu, la dimension du temps est également rassurante. Nous avons un projet engagé, qui permettra aux chercheurs de trouver une solution dans le temps, sans brûler les étapes. Grâce à ce site de stockage, nous pouvons répondre à l'exigence immédiate de prendre en charge les déchets existants des cinquante-huit réacteurs. En revanche, le centre en lui-même ne peut pas gérer l'avenir des solutions nucléaires dans notre pays. Le fait que nous ayons du temps devant nous au-delà de l'immédiat, permet de travailler avec sérieux et de façon contradictoire, pour progresser.

Je voudrais vraiment vous remercier d'avoir eu le courage d'ouvrir des pistes, en mesurant que le chemin n'était pas éclairé dans sa totalité. Vous avez à juste titre considéré qu'il aurait été criminel de priver de cette perspective une opinion attentive, prête à soutenir les projets dont l'éthique scientifique et la gestion dans le temps paraissent raisonnables.

Examen de la note scientifique sur les accélérateurs de particules (Cédric Villani, député, rapporteur)

– Mes chers collègues, le sujet de la note que je vais vous présenter est proche de celui que nous venons de développer, puisqu'il porte sur les accélérateurs de particules. Sans nul doute, nos invités pourront enrichir les débats.

Il s'agit de la douzième note scientifique préparée par l'Office depuis la mise en place de ce format il y a un an. Elle concerne le thème des grands accélérateurs de particules, que nous aborderons, d'une part, sous l'angle scientifique et technologique, et, d'autre part, sous l'angle des projets en cours, en discussion ou en projection pour le futur. Comme les autres productions, cette note se présente sous la forme d'un texte de quatre pages, suivi de deux pages de notes et références. La liste des personnes interrogées sera ajoutée dans le texte final. De mémoire, une dizaine d'experts ont été consultés au CERN, au CNRS et au CEA notamment. En outre, des contacts ont été pris avec les représentants du projet japonais.

Les grands accélérateurs de particules sont des infrastructures permettant à de nombreuses équipes de recherche de travailler sur des dispositifs coûteux, se chiffrant parfois en milliards d'euros, avec des buts scientifiques différents, ce qui justifie une attention très particulière.

Au départ, les accélérateurs ont été conçus pour explorer la matière à travers des états de très haute énergie. Certaines particules élémentaires sont ainsi accélérées à une très grande vitesse, proche de la lumière, et sont éventuellement amenées à entrer en collision. L'objectif est d'explorer certains composants de la matière, comme si une valise étanche devait être explosée pour en analyser les débris. En allant à de très hautes vitesses, on arrive à des conditions physiques propices à la mise en évidence de particules de plus en plus élémentaires, de la même façon que l'on imagine la nature naissant à partir des conditions extrêmes du Big Bang.

Au cours de l'année 2019, plusieurs projets de grands équipements de recherche dans le domaine de la physique des particules seront envisagés en Europe et en Asie. Plus particulièrement, une annonce, très attendue dans la communauté de la physique des particules, devrait concerner en mars prochain un projet japonais. De cette décision, dépendra aussi la stratégie européenne sur ces grands équipements.

La note commence par un rappel sur le modèle standard, qui est une façon de classer les particules élémentaires et les interactions fondamentales. L'idée développée est que les protons, électrons, neutrons tels qu'appris au lycée, ne sont pas les particules les plus fondamentales. Les protons et neutrons sont eux-mêmes constitués de quarks, qui sont des bribes de matière ordinaire. Dès les années 1950, le neutrino a été ajouté. Il s'agit d'une particule électriquement neutre, fascinante par sa très faible masse et ses interactions quasi nulles avec la matière.

Finalement, une douzaine de particules fondamentales constituant la matière, dénommées fermions, quarks et leptons, ont été mises en évidence.

Les hadrons sont les particules constituées de quarks comme le proton. Ils ont donné leur nom au plus célèbre accélérateur de particules au monde, géré par le CERN à Genève : le Large Hadron Collider (LHC). Son rôle est d'accélérer des hadrons pour les faire entrer en collision.

Les bosons sont d'autres exemples de particules élémentaires qui font office de messager entre particules, pour transmettre des interactions. La découverte et l'identification des bosons - les bosons Z et W, d'une part, le boson de Higgs, d'autre part – ont constitué des étapes fondamentales dans la connaissance de la matière. Ces découvertes ont donné lieu, à chaque fois, à l'attribution du prix Nobel à leurs auteurs.

Les accélérateurs de particules utilisent un champ électrique, un champ magnétique et un vide poussé. Ce sont de très grands dispositifs, mis au défi par les nouvelles techniques développées par Gérard Mourou et ses équipes, ces derniers proposant, à base de lasers ultra rapides, des accélérations sur des distances beaucoup plus courtes.

Le premier accélérateur mis au point dans les années 1930, dénommé cyclotron, avait une forme essentiellement circulaire. Puis une nouvelle catégorie d'accélérateurs de type synchrotron a vu le jour, dans lesquels le champ magnétique varie en fonction de l'énergie des particules accélérées.

Les nouveaux accélérateurs se divisent en synchrotrons et en collisionneurs. Dans le premier cas, il s'agit surtout de produire des rayonnements de grande intensité, qui sont utilisés dans divers domaines tels que la biologie, la chimie, l'astrophysique et l'archéologie. Dans l'autre cas, les collisionneurs continuent à faire s'entrechoquer différentes particules, pour analyser les débris de ces collisions. Ces équipements sont répartis de manière très inégale dans le monde : aucun en Afrique, un seul en Amérique du Sud, plusieurs au Japon, ainsi qu'en Europe. Le Japon est sans doute le pays dans lequel ces grands instruments sont les plus nombreux.

Toutefois, le plus célèbre d'entre eux est celui du CERN, créé au lendemain de la Seconde Guerre mondiale dans un but aussi bien scientifique que politique, de réconciliation entre les peuples européens. Cet accélérateur est aujourd'hui devenu emblématique par ses résultats mais également par son mode de travail. En effet, il est géré par un consortium d'États et accueille des chercheurs du monde entier. Il est devenu la plus grande collaboration scientifique du monde. Au sein du CERN, la composante la plus célèbre est le LHC, enfoui à cent mètres sous terre et mesurant vingt-sept kilomètres de circonférence. Comptant près de dix mille aimants, dont une partie à supraconducteurs, il accélère des protons à très haute énergie et à une vitesse extrêmement élevée. Le LHC est un vrai prodige de technologie.

C'est le CERN qui a mené à la découverte des bosons W et Z (prix Nobel de Carlo Rubbia et Simon van der Meer). C'est aussi le CERN qui a permis la mise en évidence, en 2012, du boson de Higgs, confirmant ainsi le modèle standard et constituant un point d'étape pour la physique fondamentale mondiale. En 2013, le prix Nobel a été remis à cette occasion à François Englert et Peter Higgs.

Pour réussir cela, il a fallu analyser, avec de puissants outils statistiques, les gigantesques masses de données produites par les collisions.

Pour sa construction, le LHC a demandé huit milliards d'euros et nécessité quinze années de travaux. Le premier faisceau de particules a été produit en 2008, et le boson de Higgs mis en évidence en 2012, comme je viens de l'indiquer.

Le CERN est également connu pour ses impacts sociétaux, en particulier la création du World Wide Web en 1989, sous la direction de Tim Berneers-Lee et de son collaborateur Robert Cailliau. Le simple fait de se placer dans des registres extrêmes en termes de conditions physiques et de production de données incite à mettre au point de nouveaux comportements, qui peuvent rejaillir sur l'ensemble de la société. Tout à l'heure, le professeur Galès évoquait le don à la médecine d'un grand accélérateur de particules pour un euro symbolique. Ici, les logiciels développés pour le Web ont été publiés sous une licence du domaine public, de sorte que tous ces résultats ont été en quelque sorte reversés gracieusement à la société.

Le modèle standard n'explique pas tout l'univers visible, connu et possible. Un certain nombre de phénomènes inexpliqués restent dans l'Univers, en particulier ceux désignés sous le nom de « matière noire » ou d'« énergie sombre ». Par ailleurs, si l'on souhaite explorer une nouvelle gamme d'énergie, les accélérateurs circulaires tels que le LHC ont leurs limites. En particulier, les cycles d'accélération et de décélération nécessités par le guidage, produisent à chaque fois de la perte d'énergie par rayonnement de freinage, désignée par le nom allemand Bremsstrahlung. L'effet étant beaucoup plus fort pour les électrons que les protons, le LHC se concentre à très haute énergie sur les protons. Quand il abrite des programmes de collision d'électrons, ceux-ci ne peuvent intervenir qu'à énergie plus basse.

Pour dépasser ces limitations et parvenir à faire collisionner des électrons à des énergies plus élevées, on en vient à planifier des accélérateurs linéaires, qui évitent cette perte d'énergie par freinage. Sur ce modèle, l'accélérateur expérimental E-XFEL, basé à Hambourg, dont le coût dépasse un milliard d'euros, permet d'accélérer les électrons sur une longueur de quelques kilomètres. Ce réacteur expérimental a été un succès, et permet de considérer la technologie comme maîtrisée.

En 2012, un projet connu sous l'acronyme ILC (International Linear Collider), a été déposé au ministère japonais de l'éducation, de la culture, des sports, des sciences et de la technologie par un consortium international de chercheurs. Ce projet ILC permettrait des collisions d'électrons et de positrons à très haute énergie sur une quinzaine de kilomètres, donc à un niveau bien supérieur à celui de l'E-XFEL. De tous les projets en compétition, l'ILC est le plus avancé dans son design. Néanmoins, son coût élevé, de 8 milliards d'euros, suscite un enthousiasme mesuré des différents acteurs.

Pour sa part, le Japon est prêt à financer une partie de ce projet, à condition que le coût total en soit réduit d'un tiers, passant de huit à cinq milliards d'euros. Corrélativement, l'énergie du collisionneur en serait réduite de moitié. Le système ainsi modifié serait insuffisant pour explorer la physique des ultra hautes énergies, qui intéresse les physiciens, mais suffisant pour réaliser des mesures de précision sur le boson de Higgs et renforcer la connaissance du modèle standard. Les conditions d'expérience et de mesure seraient en effet bien meilleures que celles du LHC. Cette innovation pourrait aussi être considérée comme une première étape, dans la mesure où les quelques milliards d'euros manquants pourraient être investis par la suite pour agrandir l'installation.

Le projet devrait être installé au Japon dans la région de Tohoku, non loin du lieu du séisme de Fukushima de 2011. C'est pourquoi l'installation de grands équipements au Japon suppose des précautions et des discussions particulières.

Les discussions prévoient des participations en nature émanant de l'Europe et des États-Unis à hauteur d'un milliard d'euros ou de dollars chacun, avec une contribution supplémentaire de l'Asie.

La question est de savoir, pour la communauté internationale et les gouvernements, dans le cadre des grands instruments, s'il faut tout miser sur le projet japonais ou garder des moyens pour d'autres projets tels que celui du futur collisionneur circulaire du CERN. Ce dernier atteindrait une circonférence de 80 à 100 kilomètres, avec une énergie dix fois plus importante que le LHC actuel et un coût total de 9 milliards d'euros, susceptible d'héberger des collisions à partir de 2040.

Faut-il conserver de la réserve aussi pour d'autres projets encore au stade de préparation au CERN, tel que le Compact Linear Collider, dont le principe et le fonctionnement se rapprochent du projet japonais, tout en gardant en tête que la Chine travaille également sur son propre projet, le Circular Electron Positron Collider ? La Chine tente de jouer sur plusieurs tableaux, avec ses propres écosystèmes et mannes financières.

De ce que nous comprenons, la réponse à la question dépendra aussi du montant que le Japon sera prêt à financer. Si ce montant est bas, la communauté scientifique internationale sera dans l'impasse car elle ne dispose pas des ressources dans le domaine de la physique fondamentale pour financer à la fois le projet du CERN et le projet ILC. Si le montant proposé par le Japon est suffisant, la situation sera beaucoup plus simple.

Tels sont, chers collègues, la problématique et le paysage des grands accélérateurs de particules pour les années à venir.

– Merci cher Cédric. Nous voyons bien la dimension de géostratégie de ces grands équipements, dont la multiplication paraît peu raisonnable. Cette note n'évoque pas les États-Unis. Pourquoi ?

– Les États-Unis ont déjà perdu la course avec le boson de Higgs.

– Selon moi, les États-Unis ont décidé de se joindre au CERN et à l'Europe. Ils semblent avoir abandonné le niveau national dans cette branche de la physique fondamentale.

– Existe-t-il une concurrence, une complémentarité sur la recherche de la collision entre les grands instruments très lourds et d'autres qui paraissent plus subtils et accessibles ?

– Je souhaiterais plutôt poser cette question à Gérard Mourou. Dans ce domaine marqué par le gigantisme, les projets peuvent maintenant atteindre la centaine de kilomètres. Y a-t-il des recherches en cours pour miniaturiser radicalement la technologie ?

– Absolument. Un grand nombre de laboratoires dans le monde travaillent actuellement dans ce domaine de « compactification » du laser. Les recherches sur la réduction des tailles sont très actives. On peut déplorer l'absence jusqu'à présent des États-Unis dans ce domaine, car ce pays était précédemment toujours à la pointe des grands projets. Depuis deux ou trois ans, les États-Unis viennent plutôt voir ce qui se passe en Europe, mais tentent actuellement de rattraper leur retard dans les lasers ultra intenses.

– Si je ne me trompe pas, il y a aujourd'hui un projet d'accélérateur laser financé par l'Europe.

– Il s'agit en effet d'une démonstration en vue de construire un véritable accélérateur laser, alors que jusqu'à présent nous avions démontré ces accélérations en laboratoire. Le projet européen vise à la construction d'un accélérateur de 4 GeV.

– On peut voir ce projet comme l'« étape zéro » permettant d'aller vers les très hautes énergies.

– Tous ces sujets sont passionnants. Lors de ma visite du CEA, un projet très important de collaboration avec Israël m'avait été exposé, le projet SARAF, non mentionné dans la note. Reste-t-il encore confidentiel ?

– J'ai insisté sur le fait que les grands accélérateurs étaient très inégalement répartis dans le monde. Nous avions réalisé une cartographie, mais la diversité est si grande qu'il est difficile de choisir un curseur. Il est très important de souligner que derrière ces grands projets, une communauté entière est attirée. C'est l'un des grands enjeux des équipements synchrotron en particulier. Celui installé au Brésil avait été l'occasion d'une importante campagne pour faire revenir les membres de la diaspora scientifique brésilienne. Pour cette raison également, la communauté internationale est mobilisée pour un grand projet en Afrique.

Le projet du Moyen-Orient est emblématique, car il permet la collaboration et la coexistence de nationalités variées dans un contexte très sensible.

– Il existe 26 000 accélérateurs dans le monde, dont 220 pour la recherche fondamentale et 70 pour les soins du cancer. Une cinquantaine d'entre eux sont des synchrotrons, avec des applications liées à la lumière. Pour revenir au projet SARAF, il se trouve qu'entre 2005 et 2011, j'étais directeur du GANIL à Caen, qui portait le projet SPIRALE 2 d'accélérateur supraconducteur. SARAF est dérivé de SPIRALE 2. J'ai personnellement voyagé et implanté les premières étapes de cette collaboration avec Israël. SARAF est un petit accélérateur de cinquante mètres de long et de 20 millions d'euros, avec une équipe relativement restreinte mais à la pointe de la technologie.

– Lorsque 3 000 personnes sont présentes dans une structure à Genève, n'ont-elles pas un regard conservateur de l'équipement existant, avec un regard biaisé sur d'autres solutions ?

– Le CERN de Genève est un point de rassemblement pour la communauté mondiale. Effectivement, l'aspect savoir-faire est considérable. Les personnes en charge du projet africain ont donc bien conscience de la nécessité de former les futurs garants du site. De plus, le fait que les projets s'étalent sur une durée aussi longue rend difficiles les changements rapides.

– Lorsque les premières expériences d'accélération laser sont apparues, nous avons d'abord été regardés avec scepticisme, comme des « chiens dans un jeu de quille », mais tel n'est plus le cas aujourd'hui. Bien sûr, le comité Nobel de physique s'inquiète pour le futur. Le dernier accélérateur qui sera construit va mesurer 100 kilomètres. Il faudra ensuite changer de paradigme, pour adopter définitivement le laser. Cependant dans l'intervalle, il paraît impossible d'arrêter les projets lancés.

– De quand datent ces premiers contacts en tant que « chien dans un jeu de quilles », puis la prise de conscience qui s'en est ensuivie ?

– Cela date des années 1990, à l'époque avec raison. Aujourd'hui, nous avons levé les objections les unes après les autres. Nous avons obtenu des qualités de faisceaux tout à fait compatibles avec ce que l'on peut souhaiter. Le laser n'est pas encore renommé pour son efficacité, mais nous avons fait beaucoup de progrès.

– La consommation électrique est un enjeu également. Le LHC représente ainsi une consommation de 1,3 TWh par année. Effectivement, le futur projet du CERN représentera trois fois plus.

– D'ailleurs, le CERN développe désormais de nouveaux projets sur l'accélération plasma. Il se situe donc sur la ligne mentionnée par Gérard Mourou.

– La tendance est désormais à l'utilisation des accélérateurs existants, pour en produire de type Wakefield et aller au-delà.

– Je félicite Cédric Villani de cette note, et d'avoir pris l'initiative de la faire publier par l'Office parlementaire. Nous avons là un outil qui consacre notre vocation, qui est d'ouvrir les yeux et l'esprit de nos collègues sur des sujets d'actualité scientifique.

– Pour l'information de nos membres présents, je précise que la liste des experts ayant contribué à cette note est la suivante : Ursula Bassler (CERN), Patrice Verdier (IN2P3), Thierry d'Almeida (CEA), Gautier Hamel de Monchenault (CEA-Irfu), Anne-Isabelle Etienvre (CEA-Irfu), Astrid Lambrecht (CNRS) et quelques autres. Ce panel en provenance de diverses institutions nous a informés et a validé l'ensemble de la note.

Nous avons vu que les deux sujets traités ce jour étaient parfaitement complémentaires, et nous ont permis d'interagir. Il nous est apparu, à Gérard Longuet et à moi-même, qu'il serait judicieux d'insérer dans la note une mention sur les recherches en cours sur le laser, afin d'inviter à la réflexion sur des chantiers engageant plusieurs décennies.

Je vous propose de considérer aussi que nous ajoutions cette note à la liste de celles déjà publiée. Le sujet est scientifique, technologique, mais également géopolitique. En cela, il est utile pour les gouvernants en général d'en être informés.

Merci pour cette matinée particulièrement intense et « lumineuse », qui nous a ouvert des horizons. Une visite du CERN est en préparation pour l'Office. En écoutant Gérard Mourou évoquer ELI, je me suis demandé s'il ne s'agirait pas d'une occasion d'approfondir le sujet. Nous avons vu à quel point à partir de considérations scientifiques communes, nous pouvions parvenir à des sujets de grande importance dans des domaines divers : connaissance de la matière, réduction des déchets nucléaires, médecine… Ce sont trois domaines radicalement différents, dont nous ne soupçonnons pas qu'ils sont liés de si près dans les laboratoires. C'est une très belle image pour la science, en lien avec la société.

– Bien entendu. Nous avons entendu les propos de nos collègues Sido et Procaccia à ce sujet. Nous pourrons nous saisir du sujet des débris spatiaux dès que les problèmes juridiques auront été maîtrisés.

– Les problèmes légaux étant de notre compétence de législateurs, nous nous en saisirons volontiers.

La séance est levée à 12 h 10

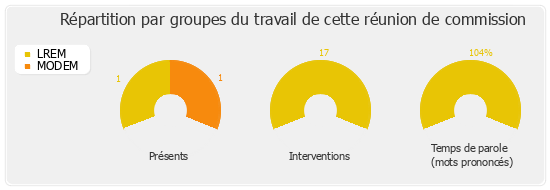

Membres présents ou excusés

Députés

Présents. - M. Philippe Bolo, M. Cédric Villani

Excusés. - M. Christophe Bouillon, M. Jean-François Eliaou, Mme Valéria Faure-Muntian, M. Jean-Luc Fugit

Sénateurs

Présents. - Mme Laure Darcos, Mme Annie Delmont-Koropoulis, M. Gérard Longuet, M. Stéphane Piednoir, Mme Angèle Préville, Mme Catherine Procaccia, M. Bruno Sido

Excusés. - M. Jérôme Bignon, Mme Florence Lassarade, M. Rachel Mazuir

ANNEXE